The Double-Edged Sword of AI’s Impact

L'impact de l'IA sur la liberté d'expression est un sujet de plus en plus important qui présente une interaction complexe de bénéfices et de défis. D'une part, les technologies de l'IA ont révolutionné la manière dont nous interagissons avec les plateformes numériques. Elles offrent des opportunités sans précédent pour la personnalisation du contenu, rendant nos expériences en ligne plus engageantes et pertinentes. Les algorithmes filtrent d'énormes quantités de données pour sélectionner du contenu qui correspond à nos intérêts, préférences et comportements passés. Ce niveau de personnalisation a rendu plus facile que jamais de trouver des informations qui nous parlent, simplifiant notre accès aux actualités, opinions et diverses formes de divertissement.

Cependant, cette merveille technologique n'est pas sans inconvénients. Les mêmes algorithmes qui personnalisent nos expériences numériques soulèvent également de sérieuses questions éthiques et légales. Ils peuvent involontairement créer des 'bulles de filtre' et des 'chambres d'écho', nous isolant de points de vue différents et renforçant nos croyances préexistantes. Cela a des implications profondes pour le discours démocratique, pouvant polariser les sociétés et limiter le débat sain. De plus, le rôle de l'IA dans la modération de contenu ouvre une autre boîte de Pandore de problèmes, y compris la censure injuste et la suppression de la liberté d'expression.

Cet article vise à disséquer la relation complexe entre l'IA et la liberté d'expression, mettant en lumière à la fois ses capacités d'autonomisation et ses pièges éthiques.

Le paradoxe de la personnalisation du contenu

La personnalisation de contenu pilotée par l'IA a transformé fondamentalement nos vies numériques. En utilisant des algorithmes complexes qui analysent notre comportement en ligne, nos préférences et nos interactions, ces technologies élaborent un flux de contenu personnalisé qui semble presque psychique dans sa précision. Les avantages sont immédiats : les utilisateurs se trouvent plus engagés, passant plus de temps sur des plateformes qui semblent les 'connaître'. Ce niveau de personnalisation améliore l'expérience utilisateur, rendant chaque interaction unique et adaptée aux besoins individuels.

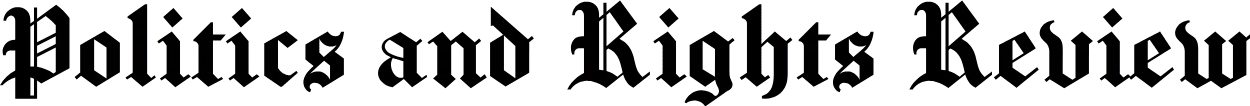

When AI algorithms decide what content we see or don’t see, they directly impact this fundamental right.

Cependant, cette expérience personnalisée n'est pas sans inconvénients. Les mêmes algorithmes qui rendent nos vies en ligne plus pratiques créent également des 'bulles de filtre' et des 'chambres d'écho'. Ces termes décrivent le phénomène où le système IA nous isole dans une sphère d'informations rassurante mais étroite.

Cette limitation restreint notre exposition à des points de vue et informations divers, créant ainsi une perception déformée de la réalité. Dans cette boucle auto-affirmative, nos croyances et opinions existantes ne sont pas seulement maintenues, mais constamment renforcées.

Le paradoxe réside dans la tension entre les avantages centrés sur l'utilisateur de la personnalisation et les coûts sociétaux de la réduction de la diversité informationnelle. Tandis que nous apprécions une expérience en ligne qui semble intimement la nôtre, nous pourrions sacrifier la richesse d'une compréhension plus variée et complète du monde qui nous entoure.

Le marécage éthique de la modération de contenu

Le rôle de l'IA dans la modération de contenu est à la fois indispensable et problématique. D'une part, les systèmes d'IA sont efficaces pour scanner de vastes quantités de données afin de signaler et supprimer le contenu qui viole les règles de la plateforme ou les normes légales. Cela est crucial pour maintenir un environnement en ligne sûr et respectueux, surtout étant donné l'énorme volume de contenu téléchargé chaque minute. Les modérateurs humains seuls seraient débordés par la tâche, sans parler du coût psychologique de la révision de contenu perturbant.

Les utilisateurs sont souvent soumis à l'influence algorithmique à leur insu sans leur consentement explicite

Cependant, les limitations de l'IA dans ce contexte sont flagrantes. Les systèmes d'IA ont souvent du mal à comprendre le contexte dans lequel les mots ou les images sont utilisés. Ils trouvent difficile de différencier entre la satire et le discours de haine réel, ou de prendre en compte les nuances culturelles qui pourraient changer la signification d'une phrase ou d'un symbole. Cela conduit à un risque élevé de 'faux positifs' et de 'faux négatifs'. Dans le cas des faux positifs, le contenu légitime peut être injustement censuré, étouffant la libre expression et impactant potentiellement le discours public. Les faux négatifs, d'autre part, permettent au contenu nocif ou illégal de passer à travers les mailles du filet, perpétuant la haine, la désinformation ou même l'activité criminelle.

Le marécage éthique ici est évident. Bien que l'IA offre une solution évolutive pour la modération de contenu, ses limitations peuvent entraîner une censure injuste ou la perpétuation de contenu nocif. Les enjeux sont élevés, impliquant non seulement les droits individuels mais aussi la santé du discours public et, en fin de compte, le fonctionnement de la démocratie elle-même.

Paysage juridique et des droits humains

L'utilisation de l'intelligence artificielle pour façonner nos expériences en ligne soulève non seulement des questions éthiques, mais a également d'importantes implications juridiques. Le droit international des droits humains est clair en ce qui concerne la liberté d'expression. Il ne protège pas seulement la liberté de diffuser de l'information, mais souligne également le droit de la recevoir. Lorsque les algorithmes d'IA décident du contenu que nous voyons ou ne voyons pas, ils impactent directement ce droit fondamental.

Le cadre juridique entourant la liberté d'expression exige que toute restriction soit prévue par la loi, serve un objectif légitime et soit nécessaire dans une société démocratique. Le rôle de l'intelligence artificielle dans la personnalisation et la modération du contenu doit être conforme à ces principes. Cela soulève des questions cruciales concernant la légalité, la légitimité et la proportionnalité dans la restriction de la liberté d'expression. Par exemple, si un système d'IA supprime ou bloque excessivement du contenu, cela pourrait être considéré comme une ingérence illégale dans la liberté d'expression.

De plus, l'absence d'un cadre juridique clair pour le rôle de l'intelligence artificielle dans la modération et la personnalisation du contenu complique les choses. Les plateformes de médias sociaux sont souvent encouragées à retirer volontairement du contenu illégal sans base juridique claire. Cette absence de clarté juridique peut entraîner des décisions arbitraires qui ne résisteront peut-être pas à un examen judiciaire, ce qui embrouille davantage une question déjà complexe.

The Council of Europe’s Warning

Le Conseil de l'Europe a tiré la sonnette d'alarme concernant les capacités de manipulation de l'intelligence artificielle dans la formation de l'opinion publique et du comportement individuel. Il ne s'agit pas seulement d'une préoccupation théorique ; c'est un problème pressant qui affecte notre manière d'interagir avec l'information en ligne. Le Conseil souligne que les systèmes d'IA peuvent influencer subconsciemment nos émotions, nos pensées, et même notre capacité à prendre des décisions indépendantes.

Cette mise en garde prend une importance particulière lorsque l'on considère que de nombreuses plateformes en ligne ne proposent pas d'option pour désactiver la personnalisation par l'intelligence artificielle. En d'autres termes, les utilisateurs sont souvent soumis involontairement à l'influence algorithmique sans leur consentement explicite. Cela soulève des questions éthiques et légales concernant l'autonomie de l'utilisateur et le droit de former des opinions sans interférence indue.

The Council of Europe’s warning serves as a crucial reminder that while AI has the potential to enrich our online experiences, it also has the power to manipulate and constrain them. Therefore, it’s imperative that regulatory frameworks are put in place to safeguard individual autonomy and freedom of expression in the age of AI.

La nécessité d'un cadre juridique

Le manque d'un cadre juridique complet régissant le rôle de l'intelligence artificielle dans la modération et la personnalisation du contenu est une lacune flagrante qui nécessite une attention urgente. Actuellement, les plateformes de médias sociaux sont largement laissées à elles-mêmes, encouragées à s'autoréguler en ce qui concerne leur contenu. Bien que cela puisse sembler être une solution pratique, cela pose d'importants problèmes de responsabilité et de transparence.

Cette approche d'autorégulation peut avoir des conséquences non voulues, telles qu'une censure excessive ou la suppression de contenu crucial pour le débat public. De telles actions portent atteinte non seulement aux libertés individuelles, mais aussi aux fondements de la société démocratique.

Par conséquent, la nécessité d'un cadre juridique n'est pas seulement une exigence bureaucratique, mais une nécessité fondamentale pour garantir que l'intelligence artificielle serve l'intérêt public sans compromettre les droits et libertés individuels. L'établissement d'un tel cadre fournirait des lignes directrices claires aux plateformes, définissant les limites de ce qui est autorisé et de ce qui ne l'est pas, tout en offrant également des voies de recours pour ceux qui estiment que leurs droits ont été violés.

Conclusion : Trouver un équilibre

Trouver un équilibre entre les avantages de l'intelligence artificielle et la préservation des droits de l'homme est une tâche complexe mais essentielle. L'impact de l'IA sur la liberté d'expression offre à la fois des opportunités et des défis. D'une part, elle peut améliorer considérablement notre expérience en ligne en personnalisant le contenu et en modérant le matériel nuisible. D'autre part, elle pose des dilemmes éthiques et juridiques qui ne peuvent être négligés.

L'absence d'un cadre juridique solide aggrave ces défis, créant un environnement flou où les lignes entre ce qui est permis et ce qui ne l'est pas sont brouillées. Ce manque de clarté peut entraîner des violations des droits fondamentaux, y compris la liberté d'expression.

Par conséquent, alors que nous continuons d'intégrer l'intelligence artificielle dans notre vie numérique, l'appel à des cadres juridiques clairs et à des directives éthiques devient de plus en plus urgent. Ces cadres doivent viser à protéger les libertés individuelles tout en laissant place à l'innovation technologique. Ce n'est qu'en atteignant cet équilibre délicat que nous pouvons nous assurer que l'intelligence artificielle serve de moyen d'autonomisation plutôt que de mécanisme de contrôle.

Adapté d'une étude académique pour un public plus large, sous licence CC BY 4.0